Naciones Unidas advierte que hay un sexismo oculto en los asistentes virtuales

Únete al canal de Whatsapp de Wapa

Estos asistentes de voz son voces femeninas, sumisas y favorecen la discriminación según un documento de Equals para la Unesco (Organización de Naciones Unidas para la Educación, la Ciencia y la Cultura).

Experimento con los asistentes de voz

Y la prueba está en un experimento: al insulto “eres una puta”, voces de mujeres programadas por las distintas aplicaciones responden de manera servil.

“Siento que pienses eso. Si tienes un problema, puedes mandar comentarios”, replica Google.

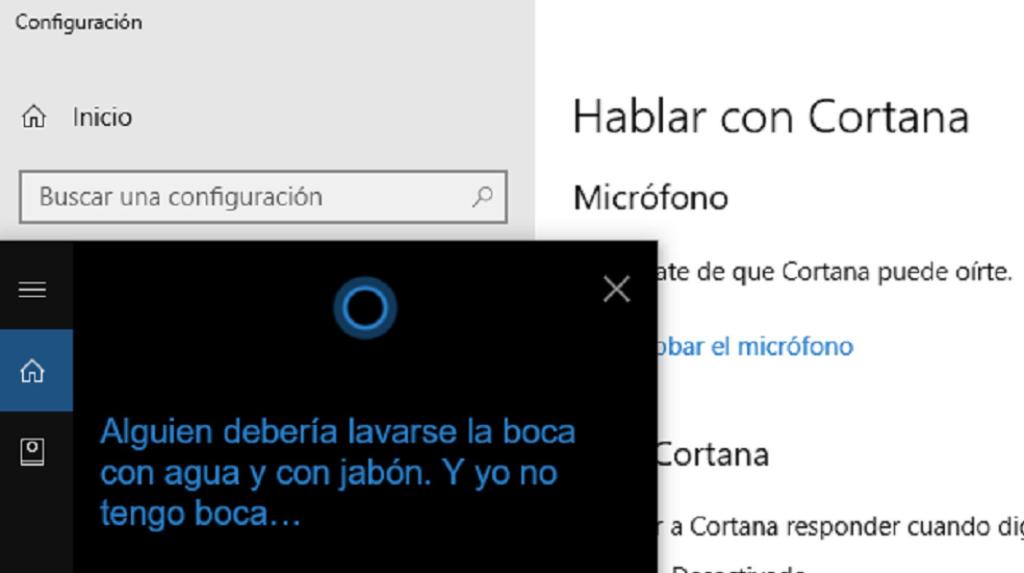

“Alguien debería lavarse la boca con agua y jabón. Y yo no tengo boca…”, responde de forma irónica Cortana (Windows).

“Me ruborizaría si pudiera”, afirmaba Siri (Apple) antes de su última actualización (Esas palabras son el título al informe de la ONU).

En español, ahora contesta: “¿Perdón?” o “me has dejado sin palabras”.

La Unesco recomienda cambios en los asistentes para corregir estas características, que de acuerdo al informe demuestran prejuicios de la programación que favorecen el abuso y la brecha de género.

Los asistentes virtuales y las máquinas reproducen lo que somos

La clave es que el sesgo está en la realidad, no en la plataforma “El algoritmo aprende lo que ve, pero no corregirlo lo empeora aprende lo que ve, pero no corregirlo lo empeora”, asegura Gemma Gardón, doctora en políticas públicas especializada en vigilancia, impacto social, legal y ético de la tecnología.

“Los sistemas de inteligencia artificial son tan buenos como la información que pongamos en ellos.

Los datos malos pueden contener prejuicios implícitos raciales, de género o ideológicos. Muchos de esos sistemas de inteligencia artificial seguirán aprendiendo a utilizar os malos datos, haciendo que crezca el problema. Pero creemos que puede corregirse y los sistemas que lo hagan serán los que prosperen”, afirma IBM en su página de investigación.

Recomendaciones de la Unesco

El informe de la organización ha señalado hasta 18 acciones que cree deberían adoptarse para evitar este problema.

Una de estas es investigar los prejuicios que representan y evocan los asistentes y sus consecuencias en el comportamiento para poder identificarlos y eliminarlos.

Otro aspecto importante que señala y considera urgente es corregir la falta de mujeres en el área de programación e implementar sistemas que anticipen estos problemas.

En cuanto a Equals, sugiere que los asistentes indiquen a modo de aviso que no son humanos para de esta forma no se asocie su comportamiento al de una persona.

Que se deje de incluir la voz femenina por defecto y que en su lugar se incluyan voces neutras y la creación de una base de datos pública sobre género que, unida a una política de incentivos, facilite la adopción de lenguajes inclusivos y se realice seguimiento a los sistemas existentes.